Ketchup auf dem Teller: Kann KI Gesellschaft besser machen?

Tutzing, 30. Januar 2024

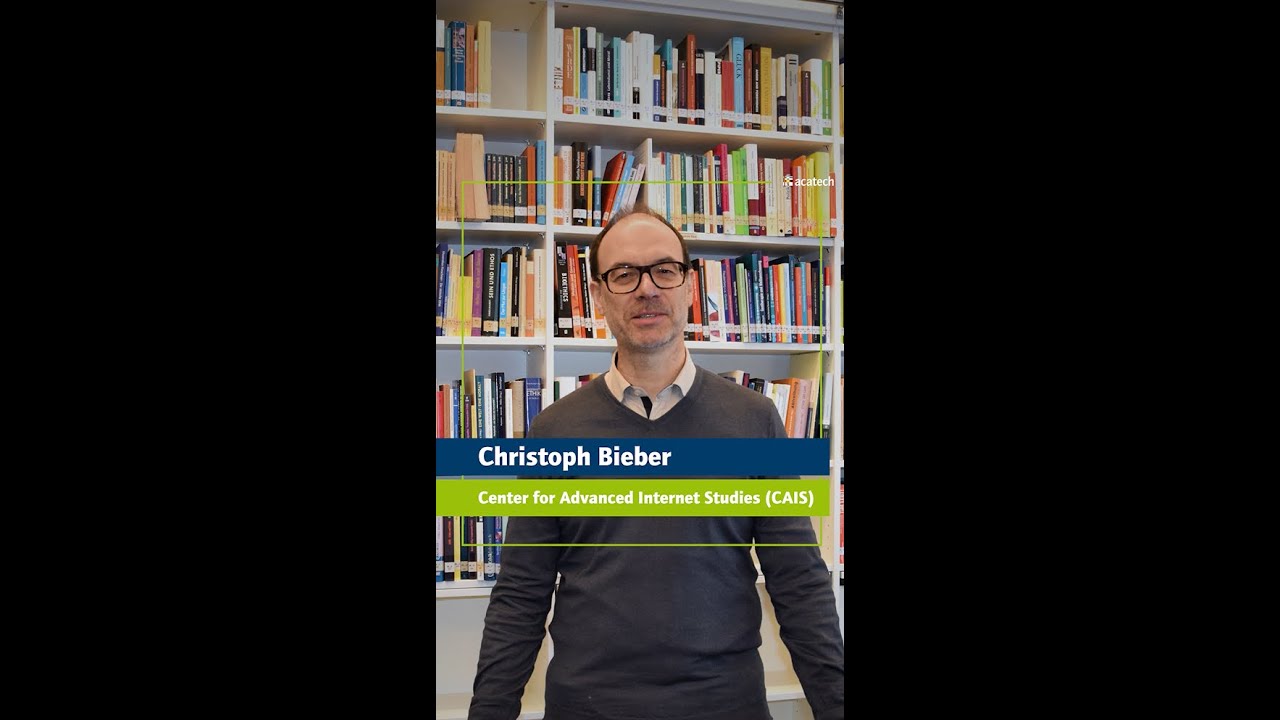

Im Bereich Künstliche Intelligenz (KI) sind in der jüngeren Vergangenheit große Durchbrüche gelungen. In Fachkreisen haben sich diese zwar lange angedeutet, jedoch haben Geschwindigkeit und Ausmaß dann doch überrascht: plötzlich war das Ketchup aus der Flasche. Welche Konsequenzen für Gesellschaft, Wirtschaft oder Medien damit verbunden sind, darüber diskutierten rund 30 Teilnehmende am 18./19. Januar bei einer zweitägigen Kooperationsveranstaltung an der Akademie für politische Bildung Tutzing. Ein Nachbericht.

Künstliche Intelligenz – „schlimmstes Ereignis in der Geschichte der Zivilisation“ (Stephen Hawking) oder verheißungsvolles Zukunftsversprechen? Seit Veröffentlichung der Software ChatGPT Ende des Jahres 2022 streitet die Welt darüber, welche Richtung KI dem Leben der Menschen geben wird. acatech Präsident Jan Wörner mahnte bei der Eröffnung der Tagung „Künstliche Intelligenz verbessert Gesellschaft?!“, die acatech am 18./19. Januar 2024 in Kooperation mit der Akademie für Politische Bildung in Tutzing veranstaltete, zu mehr Besonnenheit: Die KI-Debatte müsse unaufgeregter geführt werden, denn auch diese Technologie werde keine neue Wirklichkeit erschaffen. Man müsse jetzt nüchtern analysieren und realistische Szenarien diskutieren, um die positive Innovationskraft der KI nicht schon im Voraus zu stark einzubremsen.

Was bedeutet KI für die Gesellschaft?

Digitaljournalist Richard Gutjahr fasste im ersten Impuls des Tages zusammen, worauf die jüngsten Durchbrüche im KI-Bereich gründen. Die Verfügbarkeit immer größerer Datenmengen aus Internet und Smartphones sowie der Zuwachs der Rechenleistung von Computern hätten den sogenannten Ketchup-Moment herbeigeführt: Nach einigem Schütteln und mehreren Entleerungsversuchen, die den Flascheninhalt nur tröpfchenweise zum Vorschein gebracht haben, hat sich die Ketchup-Masse im Gefäß schließlich so angeordnet, dass sich die Glasflasche schlagartig stark leert. Mit ChatGPT und anderen Anwendungen generativer KI ist nun also eine große Menge Ketchup auf den Teller gelangt – wie damit umgehen?

Während Richard Gutjahr mögliche negative Auswirkungen von KI auf die Gesellschaft – das Verschwinden von Arbeitsplätzen, die Zunahme von Cyberkriminalität oder eine schleichende Desozialisierung – in den Blick nahm, rückte Andrea Martin, Leiterin des IBM Watson Center Munich und CTO Ecosystem & Associations bei IBM DACH, das Potenzial für die Wirtschaft in ihrem Vortrag in den Mittelpunkt. KI könne beispielsweise dabei helfen, den Kundenservice zu optimieren, dem Management eine bessere Grundlage für Entscheidungen bereitstellen oder Lieferketten resilienter zu machen. Das Ziel sei es, mithilfe von KI menschliche Intelligenz zu erweitern. Und genau das müsse entsprechend kommuniziert werden, damit die Menschen Vertrauen in eine neue Technologie entwickeln könnten, die unzweifelhaft große Erleichterungen und Vorteile mit sich bringen werde.

Diese Erleichterungen und Vorteile behandelte auch acatech Präsidiumsmitglied Ortwin Renn in seinem anschließenden Impuls: Genauso wie andere erfolgreiche Innovationen zuvor sei KI ein Versprechen für ein Mehr an Effizienz, Effektivität, Komfort, Resilienz und Gerechtigkeit. Das lasse sich gut im KI-Anwendungsfeld „Autonomes Fahren“ beobachten. Ebenso aber könne KI – wie jede Technik – auch negative Tendenzen verstärken: Während KI-Fachkundige von der Technologie profitierten, könnten andere aufgrund ihres Wissenstandes von den Vorteilen ausgeschlossen sein – wodurch sich am Ende bestehende Gräben vergrößern bzw. neue auftun könnten.

Künstliche Intelligenz und Medienwandel

In drei parallellaufenden Workshops konnten die Tagungsteilnehmenden im Anschluss tiefer in die Themen „KI in der Wissenschaftskommunikation“, „Digitaler Medienwandel“ und „Technische Tools gegen Desinformation und Deepfakes“ eintauchen.

Während die acatech Mitglieder Eva-Maria Jakobs (ehem. RWTH Aachen) und Mike S. Schäfer (Universität Zürich) in ihrem Workshop unter anderem der Frage nachgingen, ob ChatGPT und andere generative KI-Anwendungen angesichts eines gestiegenen Misstrauens in Medien, Politik und Wissenschaft in eine Lücke stoßen und zum vertrauenswürdigen Lieferanten „entpersonalisierter Wahrheit“ werden könnten, beschäftigten sich die Workshop-Leitenden Christoph Neuberger (FU Berlin) und Gudrun Riedl (Bayerischer Rundfunk) mit der Rolle von KI im journalistischen Alltag. Die Beteiligten des Workshops waren sich am Ende weitestgehend einig, dass der Journalismus auch in naher Zukunft nicht ohne den Menschen auskomme – in seiner Funktion als Interviewer, Faktencheckerin oder Gatekeeper sei der Mensch nach wie vor unverzichtbar. Jedoch, bekräftigte Gudrun Riedl, müssten Journalistinnen und Journalisten KI in ihre Arbeit einbauen und die Vorteile der Technologie nutzen.

Interview mit Gudrun Riedl, Redaktionsleiterin BR24 Digital, Bayerischer Rundfunk, München, zur Frage: „Wie gehen Digital-Redaktionen mit den Herausforderungen der KI um?“

Anknüpfend an die acatech Themenkonferenz zu Desinformation wurden im dritten Workshop die Gefahren von Desinformationen und Deepfakes diskutiert. Zur Bekämpfung dieser Phänomene, so Workshop-Leiter Thorsten Quandt (Universität Münster), müssten Bündel von Maßnahmen zur Anwendung kommen: Es gehe beispielsweise um eine Stärkung der Medienkompetenz innerhalb der Bevölkerung, die Kontextualisierung von Suchmaschinenergebnissen (um damit eine weitere Quellenrecherche zu ermöglichen) oder den Einsatz KI-gestützter Tools zur Erkennung von Deepfakes. Jedoch müsse man beim „Debunking“, dem Versuch des Aufdeckens und Ausräumens von Desinformation, bedenken, dass dieses Handeln auch kontraproduktiv sein könne. Im schlechtesten Fall entstehe nämlich auf diese Weise noch mehr Misstrauen, falsche Meinungen verfestigten sich und führten zu einer weiteren Polarisierung.

Den Abschluss der ersten Tagungshälfte bildete eine Podiumsdiskussion, moderiert von Andreas Kalina von der Akademie für Politische Bildung in Tutzing. acatech Präsident Jan Wörner warb darin nochmal dafür, die Chancen und Risiken von KI realistisch zu bewerten. Die Risiken – seine Mitdiskutantin Gitta Kutyniok (LMU München, Plattform Lernende Systeme) verwies beispielsweise auf die Möglichkeit KI-basierter Diskriminierung – seien zwar unzweifelhaft vorhanden, ließen sich aber in den Griff bekommen, zum Beispiel, indem man KI-Anwendungen von unabhängiger Stelle überprüfen und zertifizieren lasse. Entsprechende KI-Qualitäts- und Prüfstandards werden aktuell im acatech Projekt MISSION KI entwickelt.

Aktuelle Entwicklungen der Künstlichen Intelligenz

Den zweiten Seminartag eröffnete Gitta Kutyniok mit einem Vortrag über Generative KI. Beim Trainieren von KI, so die Mathematikerin, mache man weiterhin große Fortschritte, doch es blieben einige Baustellen. So sei nach wie vor viel zu häufig zu beobachten, dass generative KI-Systeme „halluzinieren“, also Ergebnisse liefern, die nicht durch Trainingsdaten gerechtfertigt zu sein scheinen und objektiv falsch sind. Darüber hinaus seien Urheberrechtsfragen nicht geklärt.

Theresa Züger (Alexander von Humboldt Institut für Internet und Gesellschaft) umriss im Anschluss das Forschungsfeld „Gemeinwohlorientierte KI“, in dem es um die Erfassung, Analyse und Entwicklung entsprechender KI-Anwendungen geht. Als Beispiele nannte sie das Projekt „Seaclear“, das KI dafür nutzt, Abfall auf dem Meeresboden zu orten und einzusammeln oder den „Simba Text Assistant“, der Website-Texte automatisch in leichte Sprache überführt. Ihre Nachrednerin Lorena Jaume-Palasí (The Ethical Tech Society) stellte schließlich noch Fälle algorithmischer Diskriminierung vor, wie sie beispielsweise in der Medizin vorkommen.

Interview mit Theresa Züger, Leiterin AI & Society Lab sowie Forschungsgruppe Public Interest AI, Alexander von Humboldt Institut für Internet und Gesellschaft gGmbH (HIIG), Berlin, zur Frage: „Was ist gemeinwohlorientierte KI und gibt es Bewertungskriterien?“

Regulation von Künstlicher Intelligenz?!

Den Abschluss der Tagung bildete eine weitere Workshopphase zum Thema „Regulation von Künstlicher Intelligenz?!“, wobei je nach Workshop die juristische, die gesellschaftliche oder die ethische Perspektive im Mittelpunkt stand.

Während Workshop-Leiter Benjamin Ledwon von der Amadeus IT Group mit seiner Gruppe die europäischen Regulierungsansätze des AI Acts diskutierte, thematisierte Ingolfur Blühdorn (Wirtschaftsuniversität Wien) in seinem Workshop das gesellschaftliche Spannungsverhältnis zwischen Autonomie und Regulation, welches eine sinnvolle Regulierung von KI so schwer mache.

Interview mit Benjamin Ledwon, Head of Amadeus EU Representation, Amadeus IT Group SA, Brüssel, zur Frage: „Der AI Act bildet einen ersten Schritt zur Regulierung von KI, ist das der richtige Weg mit KI umzugehen oder erst der Anfang?“

Anhand zweier Anwendungsfälle aus dem Bereich „Smart City“ demonstrierte Christoph Bieber (Center for Advanced Internet Studies, Plattform Lernende Systeme) in seinem Workshop die Komplexität der ethischen Perspektive. So werde am Beispiel einer KI-gestützten Parkraumüberwachung deutlich, dass auch übergreifende Kontexte relevant sind. Schließlich stelle sich in diesem Zusammenhang die Frage, ob eines der ersten Smart-City-Projekte ausgerechnet zur Sanktionierung von Bürgerinnen und Bürger genutzt werden sollte. Es brauche einen organisatorischen Rahmen für Debatten (z.B. ethische Beratungsgremien), die Probleme jenseits rechtlicher oder technologischer Fragen erörtern und politische Entscheiderinnen und Entscheider im Vorfeld von Abstimmungen unterstützen können.

Interview mit Christoph Bieber, Center for Advanced Internet Studies (CAIS) gGmbH, Bochum, zur Frage: „Wie können ethische Herausforderungen beim Einsatz bzw. der Entwicklung von KI-Systemen mitgedacht werden?“

Mit einer gemeinsamen Abschlussdiskussion ging die zweitägige Veranstaltung zu Ende. Die zahlreichen unterschiedlichen Impulse zeigten deutlich, dass es nicht die eine, schnell umsetzbare Lösung gibt, um den richtigen Umgang mit KI zu finden. Es wird viele weitere Diskussionen geben müssen, um die aufgeworfenen Fragen zu klären.